1. Revisão Avançada da Arquitetura Transformer

Para criar bons prompts, não precisamos ser cientistas da computação, mas ajuda muito entender como o "cérebro" da IA funciona. O nome desse cérebro é Transformer, e ele é a base de modelos como o GPT, Gemini e outros.

O grande superpoder do Transformer é sua capacidade de entender o contexto. Ele não lê as palavras uma de cada vez, isoladamente. Ele olha para a frase inteira de uma vez só e descobre como as palavras se relacionam umas com as outras. Para fazer isso, ele usa duas ferramentas mágicas:

Atenção Multi-Cabeça (Multi-Head Attention): Imagine que você contrata uma equipe de detetives para ler uma frase. Cada detetive (uma "cabeça") tem uma especialidade diferente:

- Um foca em descobrir "quem fez o quê".

- Outro foca em "onde" a ação aconteceu.

- Um terceiro foca em adjetivos, entendendo as qualidades das coisas.

Codificações Posicionais (Positional Encodings): O Transformer olha todas as palavras de uma vez, mas a ordem delas importa, certo? "O cachorro mordeu o homem" é muito diferente de "O homem mordeu o cachorro". A Codificação Posicional é como dar um "crachá" com um número de série para cada palavra, dizendo: "Você é a 1ª palavra", "Você é a 2ª", e assim por diante. Isso garante que o modelo nunca perca o sentido da ordem.

Atenção Multi-Cabeça (Multi-Head Attention)

Imagine que você contrata uma equipe de detetives para ler uma frase. Cada detetive (uma "cabeça") has uma especialidade diferente:

- Um foca em descobrir "quem fez o quê".

- Outro foca em "onde" a ação aconteceu.

- Um terceiro foca em adjetivos, entendendo as qualidades das coisas.

Depois de lerem a frase, todos os detetives se reúnem e compartilham suas anotações. O resultado é uma compreensão muito mais rica e completa do que se apenas uma pessoa tivesse lido. É isso que a Atenção Multi-Cabeça faz.

Codificações Posicionais (Positional Encodings)

O Transformer olha todas as palavras de uma vez, mas a ordem delas importa, certo?

"O cachorro mordeu o homem" é muito diferente de "O homem mordeu o cachorro".

A Codificação Posicional é como dar um "crachá" com um número de série para cada palavra, dizendo: "Você é a 1ª palavra", "Você é a 2ª", e assim por diante. Isso garante que o modelo nunca perca o sentido da ordem.

Analogia: Pense no Transformer como um chefe de cozinha genial preparando um prato. Ele não olha os ingredientes um por um. Ele olha para todos os ingredientes na bancada de uma vez (a frase inteira), entende como o sal vai realçar o sabor do tomate e como o azeite vai combinar com o manjericão (Atenção). Ao mesmo tempo, ele sabe a ordem exata da receita (Codificação Posicional) para que o prato saia perfeito.

2. Mecanismos de Atenção e Conhecimento

Já falamos que a "Atenção" é um superpoder, mas vamos nos aprofundar. A atenção é, literalmente, a habilidade do modelo de dar mais importância a certas palavras enquanto gera uma resposta.

Quando você faz uma pergunta, o modelo não trata todas as palavras do seu prompt da mesma forma. Ele rapidamente aprende quais são as palavras-chave, os verbos de comando, e o contexto mais importante. Ele "pinta" essas palavras com um marcador invisível para mantê-las em foco.

Como engenheiros de prompt, nosso trabalho é facilitar esse processo. Um bom prompt é aquele que usa uma linguagem clara, com instruções diretas e, se necessário, delimitadores (como ``` ou ###) para dizer ao modelo: "Ei, preste muita atenção a esta parte aqui!". Ao fazer isso, estamos guiando o mecanismo de atenção dele, o que leva a respostas muito mais relevantes.

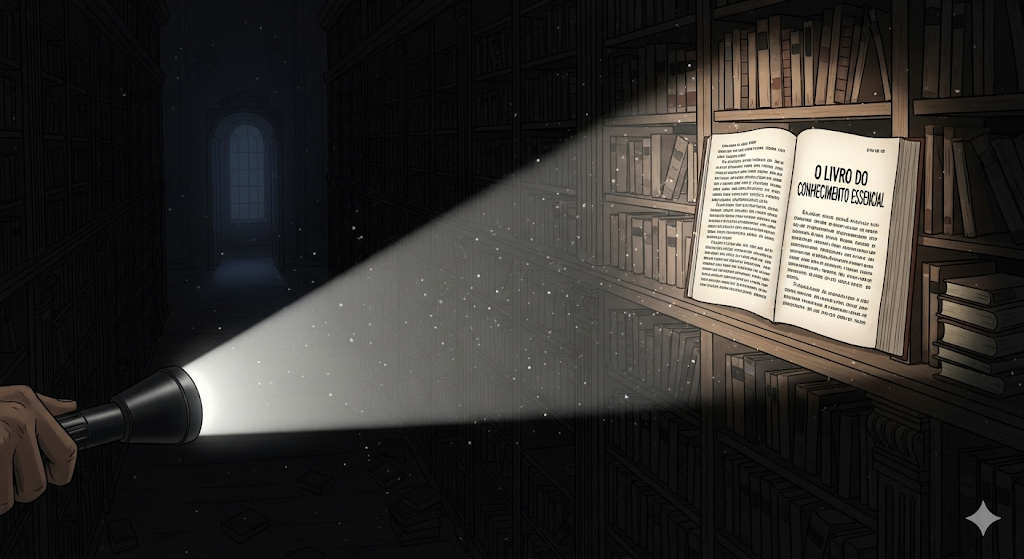

Analogia: Imagine que o conhecimento do modelo é uma biblioteca gigantesca e escura. Sua pergunta é uma lanterna. O mecanismo de atenção é a capacidade do modelo de focar o feixe de luz da lanterna exatamente na prateleira e no livro certos para encontrar a resposta, ignorando todo o resto da biblioteca.

3. Interpretabilidade Mecanística

Os LLMs são frequentemente chamados de "caixas-pretas". Eles funcionam incrivelmente bem, mas por dentro são uma teia tão complexa de conexões matemáticas que até seus criadores não sabem exatamente o que cada parte faz.

A Interpretabilidade Mecanística é o esforço de cientistas para abrir essa caixa-preta e mapear o que está dentro. É um trabalho de detetive para descobrir, por exemplo, qual conjunto específico de neurônios artificiais é responsável por identificar o conceito de "ironia" em um texto, ou qual circuito é ativado quando o modelo está raciocinando sobre física.

Para nós, isso é importante porque, quanto mais entendemos como o modelo "pensa", melhor podemos formular nossos prompts para "falar a língua dele" e ativar os circuitos certos para o que precisamos.

Analogia: É como um neurocientista estudando um cérebro. O cérebro funciona, mas o cientista quer saber qual área específica é responsável pela fala, pela memória ou pela emoção. A Interpretabilidade Mecanística faz o mesmo, mas com o cérebro artificial do LLM.

4. Circuitos Neurais e a Emergência de Habilidades

Aqui está uma das ideias mais fascinantes da IA: ninguém programou o ChatGPT para ser criativo ou para escrever código. Essas habilidades complexas "emergiram" (surgiram espontaneamente) da interação de regras muito simples em uma escala massiva.

Um único neurônio artificial é muito simples, ele apenas processa um sinal matemático. Mas quando você conecta bilhões deles e os treina com quase toda a informação da internet, eles começam a se organizar em "circuitos" especializados. Pode haver um circuito para formar frases corretas, outro para reconhecer padrões lógicos, outro para identificar sentimentos.

A "mágica" acontece quando esses circuitos começam a trabalhar juntos. A habilidade de escrever um poema, por exemplo, pode emergir da combinação do circuito de vocabulário, do circuito de rimas e do circuito de emoções. A engenharia de prompt, então, é a arte de criar uma entrada que estimule a combinação certa de circuitos para a tarefa desejada.

Analogia: Pense em uma colônia de formigas. Cada formiga segue regras muito simples (seguir o feromônio, pegar comida, etc.). Nenhuma formiga individual tem a planta de um formigueiro na cabeça. No entanto, a partir da interação de milhares de formigas seguindo regras simples, emerge um formigueiro complexo e super eficiente. As habilidades do LLM emergem da mesma forma.

5. Análise de Viés e Alucinação na Origem

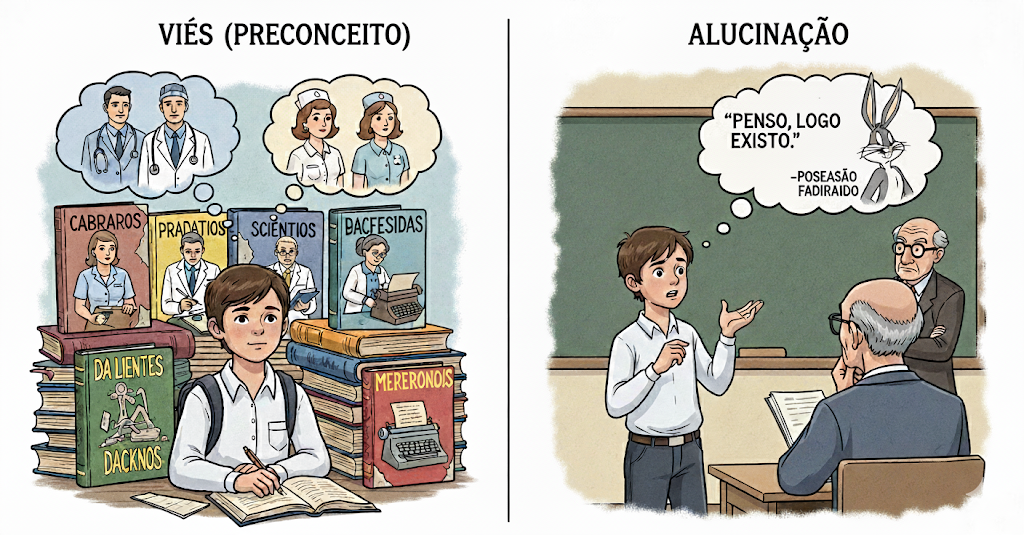

O modelo aprendeu com dados criados por humanos, e por isso, ele herda nossas falhas. É crucial entender duas delas:

Viés (Bias): Se os dados de treinamento continham, por exemplo, mais textos associando "médicos" a homens e "enfermeiras" a mulheres, o modelo aprenderá essa associação e a reproduzirá. Isso é um viés. Ele pode criar estereótipos e dar respostas injustas. Parte do nosso trabalho é criar prompts que desafiem esses vieses ou que peçam por uma perspectiva neutra.

Alucinação (Hallucination): Isso acontece quando o modelo inventa fatos, datas, citações ou fontes com total confiança. Ele não faz isso para mentir; ele faz isso porque seu objetivo principal é prever a próxima palavra mais provável. Se uma resposta "parece" correta e plausível, ele a gera, mesmo que não tenha base na realidade. É fundamental sempre checar informações críticas que o modelo fornece.

Analogia: Imagine um estudante muito esforçado, mas um pouco ansioso.

• Para o Viés, imagine que ele só estudou por uma coleção de livros antigos que continham visões ultrapassadas. As respostas dele, embora inteligentes, vão refletir o preconceito desses livros.

• Para a Alucinação, imagine que o professor faz uma pergunta para a qual ele não sabe a resposta. Em vez de admitir, ele fica nervoso e inventa uma resposta que soa inteligente, misturando fatos que ele conhece, na esperança de acertar. É uma resposta confiante, mas incorreta.